Astuces et conseils :Tout savoir sur l’indexation de Google

Qu’est-ce que l’index de Google ?

C’est une sorte de catalogue massif qui répertorie et organise toutes les pages web du monde. Imaginez-le comme un énorme guide qui classe chaque site selon son contenu, le rendant plus facile à trouver lorsque vous effectuez une recherche en ligne. Des programmes automatisés parcourent constamment le web, collectant des informations sur chaque page et les ajoutant à ce répertoire géant. Ensuite, un système sophistiqué évalue ces données, déterminant quelles pages sont les plus pertinentes pour différentes requêtes de recherche.

En résumé, c’est comme la carte maîtresse qui guide les utilisateurs d’internet vers les informations qu’ils recherchent. Avoir son site répertorié correctement dans cet annuaire virtuel est essentiel pour qu’il soit découvert par les internautes. Pour s’assurer d’y figurer, il est important d’optimiser son site web, en utilisant des techniques qui attirent l’attention de ces programmes d’exploration automatisés.

Il représente une étape cruciale que tout site doit franchir pour être visible sur les résultats de recherche. Malheureusement, de nombreuses personnes rencontrent des difficultés à être correctement indexées, ce qui pose un problème majeur, car sans indexation, le site demeure pratiquement invisible.

Comment fonctionne l’indexation de Google ?

C’est un processus qui permet à chaque page web d’être répertoriée et classée, influençant directement sa visibilité dans les résultats de recherche. Jetons un regard approfondi sur cette mécanique complexe pour comprendre comment Google organise

1. L’exploration du web : Les Googlebots en Action

Au commencement, les robots d’exploration, tels des archéologues numériques, parcourent le web. Ils suivent les liens d’une page à l’autre, analysant le contenu et collectant des données cruciales.

La première étape est cruciale pour le processus d’indexation de Google. Elle commence par une exploration minutieuse menée par les Googlebots, également appelés crawlers. Ces acteurs jouent un rôle essentiel dans la compréhension et la catégorisation du contenu de votre site web. Cette phase initiale est vitale, car elle influence directement la manière dont votre site sera présenté dans les résultats de recherche.

Les Googlebots poursuivent deux objectifs fondamentaux lors de cette phase exploratoire :

- Comprendre la thématique générale de votre site :

Imaginez les Googlebots comme des détectives virtuels parcourant chaque recoin de votre site pour en extraire des indices et comprendre sa nature globale. Tel un enquêteur perspicace, chaque crawler s’efforce de saisir la thématique générale de votre site. Cette première mission revêt une importance capitale, car elle permet aux Googlebots de classer votre site dans une catégorie spécifique, facilitant ainsi son repérage lors des prochaines recherches des internautes - Comprendre la thématique/le sujet principal de chaque page :

Une fois la thématique globale établie, les Googlebots se penchent sur chaque page individuelle de votre site. C’est ici que réside la finesse du processus, car chaque page est minutieusement analysée pour extraire son sujet principal. Le Googlebot décortique le contenu, évaluant les mots-clés, la structure et le contexte pour déterminer de quoi traite chaque page. Cette étape permet aux Googlebots de cataloguer votre site dans l’index de Google de manière précise, garantissant ainsi que chaque page soit associée au sujet qui la définit le mieux.

2. L’indexation Google : Indexation des pages et de leurs positionnements

Lorsque l’on plonge dans l’univers complexe du SEO, comprendre l’indexation des pages et leur positionnement devient impératif. Ces concepts jouent un rôle fondamental dans la manière dont votre site est perçu par les moteurs de recherche, en particulier par le mastodonte de la recherche en ligne, Google.

Index Google : Catégorisation et hiérarchisation

À la suite de cette analyse, vos pages ne restent pas dans l’ombre du web. Elles sont soigneusement ‘catégorisées’ dans l’index de Google. Pour illustrer cela, imaginons un site spécialisé dans la vente de fraises. Il pourrait être rangé dans les sections « Alimentation » ou « Produits alimentaires ». Plus spécifiquement, il pourrait être associé à des mots-clés tels que « Fraises » ou « Fruits frais ». Une stratégie de mots-clés astucieuse peut donc faire toute la différence face à vos concurrents.

Chaque détail compte dans la catégorisation, impactant directement sa visibilité. Suivre avec rigueur cette étape cruciale du processus d’indexation est essentiel pour s’assurer que votre site trouve sa place privilégiée dans les résultats de Google.

Répondre aux attentes des internautes

Pourquoi ces Googlebots analysent-ils vos pages ? La réponse est simple : offrir le meilleur résultat possible aux internautes. Google, en tant qu’entreprise, s’efforce constamment de proposer les résultats les plus pertinents et une expérience utilisateur optimale.

Quelques astuces qui va vous permettre de booster l’indexation de votre site

L’indexation de votre site est la base de votre SEO, et pour vous guider dans cette quête. Voici quelques astuces incontournables qui vous permettront d’optimiser ce processus et d’améliorer la visibilité de votre site sur les moteurs de recherche.

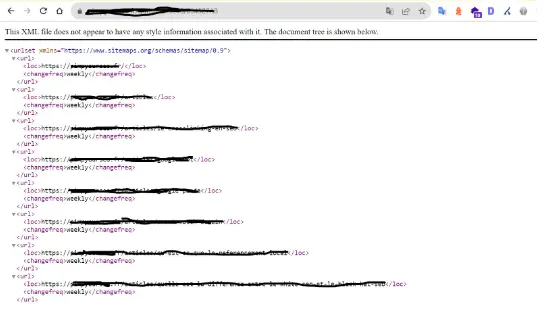

Le Sitemap.xml 🗺️ : Hiérarchisez et Notifiez !

Le Sitemap.xml est un outil puissant pour guider les Googlebots dans la jungle de votre site. Voici comment en tirer le meilleur parti :

- Hiérarchisation claire : Le Sitemap.xml offre une vue structurée de votre site, indiquant clairement les pages importantes.

- Facilitation du crawl : En listant toutes les URLs cruciales, le Sitemap.xml facilite le travail des Googlebots, améliorant l’efficacité de l’indexation. Qu’est-ce que le crawl ? Le crawl est l’analyse d’une page d’un site et/ou d’un site de manière générale

- Notification des changements : Indiquez la fréquence de mise à jour des pages pour une indexation rapide. Utilisez les balises

<changefreq></changefreq>pour préciser la fréquence. - Inclusion de médias : Si votre site contient des médias riches, comme images et vidéos, le Sitemap.xml les inclut, améliorant leur indexation sur la SERP image de Google.

Sitemap.xml pour WordPress :

Pour les utilisateurs de WordPress, vous pouvez utiliser des plugins comme Yoast SEO qui génèrent automatiquement un sitemap.xml.

Sitemap.xml pour Shopify :

Shopify génère automatiquement un sitemap.xml pour votre boutique. Assurez-vous qu’il est accessible à cette URL : https://ta-boutique.myshopify.com/sitemap.xml

4.2 Le Sitemap HTML/Plan de Site 📄 : Priorisez l’Expérience Utilisateur !

Créer un plan de site est très intéressant, car cela vous permet d’améliorer l’expérience utilisateur en mettant à disposition une page accessible qui facilite la navigation sur votre site et aide les internautes à comprendre la structure de celui-ci. Je vous conseille de placer votre plan de site dans le footer. D’ailleurs, ne créez pas de plan de site si vous avez un petit site.

En élaborant un plan de site comprenant tous les liens de votre site, vous serez en mesure de le fournir aux Googlebots. Mon conseil est d’effectuer une indexation manuelle via la Search Console. Cela vous permettra de prioriser l’indexation de la page auprès de Google. Lui permettant ainsi d’analyser tous les URLs qu’elle contient. Si vous vous rappelez de ce que j’ai mentionné sur le comportement des Googlebots, lorsqu’ils parcourent votre plan de site, ils examinent les liens de la page, englobant ainsi l’ensemble des liens de votre site. Les Googlebots ont une affinité particulière pour les liens ! En conséquence, notre budget crawl sera optimisé !

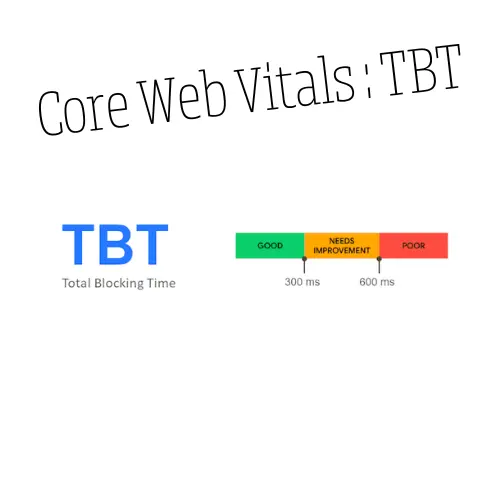

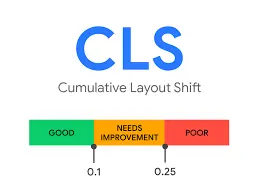

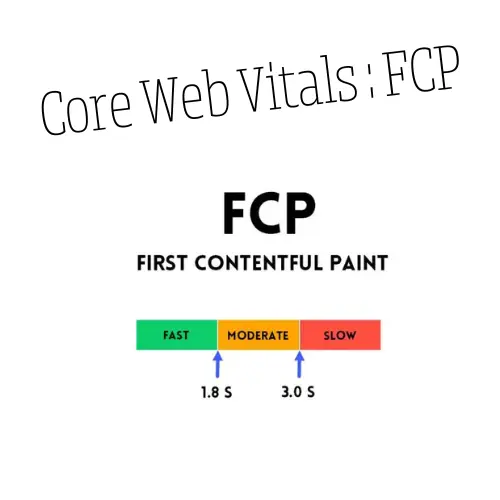

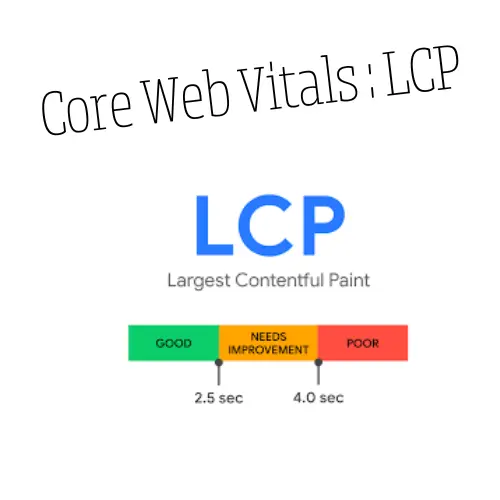

Boostez l’efficacité du crawl : Améliorer la vitesse de page

L’amélioration des performances web, en particulier la vitesse de chargement des pages peut influencer positivement l’indexation de vos pages par les Googlebots. Voici quelques raisons pour lesquelles cela se produit :

- Un crawling plus efficace : Des pages qui se chargent rapidement permettent aux Googlebots de parcourir et d’explorer davantage de contenu en moins de temps. Une vitesse de chargement plus rapide signifie que les robots d’exploration peuvent traiter plus de pages pendant une session de crawl, améliorant ainsi l’efficacité globale du processus d’indexation.

- Priorité aux pages pertinentes : Si Google doit choisir entre indexer deux pages similaires, il peut favoriser celle qui se charge plus rapidement. Une performance web optimale peut donc jouer en faveur de l’indexation prioritaire de vos pages dans les résultats de recherche.

- Budget crawl optimisé : Un site rapide peut être exploré plus efficacement avec le même budget crawl. Les Googlebots peuvent visiter plus de pages en moins de temps, ce qui est particulièrement crucial si vous avez un grand nombre de pages à explorer.

Le budget de crawl représente la capacité qu’a un moteur de recherche d’explorer et d’indexer les pages d’un site web en une période donnée. Cela détermine la fréquence à laquelle les Googlebots visitent et analysent les pages de votre site. Un budget de crawl bien géré est essentiel pour optimiser l’indexation et maintenir la fraîcheur des données dans les résultats de recherche. - Signal de qualité : La vitesse de chargement est également un signal de qualité pour Google. Des pages rapides sont souvent considérées comme plus fiables et professionnelles, ce qui peut influencer positivement la perception de Google et son traitement en termes d’indexation.

Résoudre les Erreurs HTTP (404) : Gardez Votre Site en Forme !

Les erreurs 404 peuvent entraver l’indexation, agissez pour les éliminer :

- Frein au crawling : Les erreurs 404 freinent le crawling, réduisant la découverte d’autres pages.

- Non-indexation de contenu : Les pages générant des erreurs 404 risquent d’être désindexées, impactant leur visibilité.

- Perte de jus de page : Les pages avec erreurs 404 perdent leur autorité.

Comment faire face aux erreurs 404 : Utilisez des redirections 301 pour conserver le jus de page.

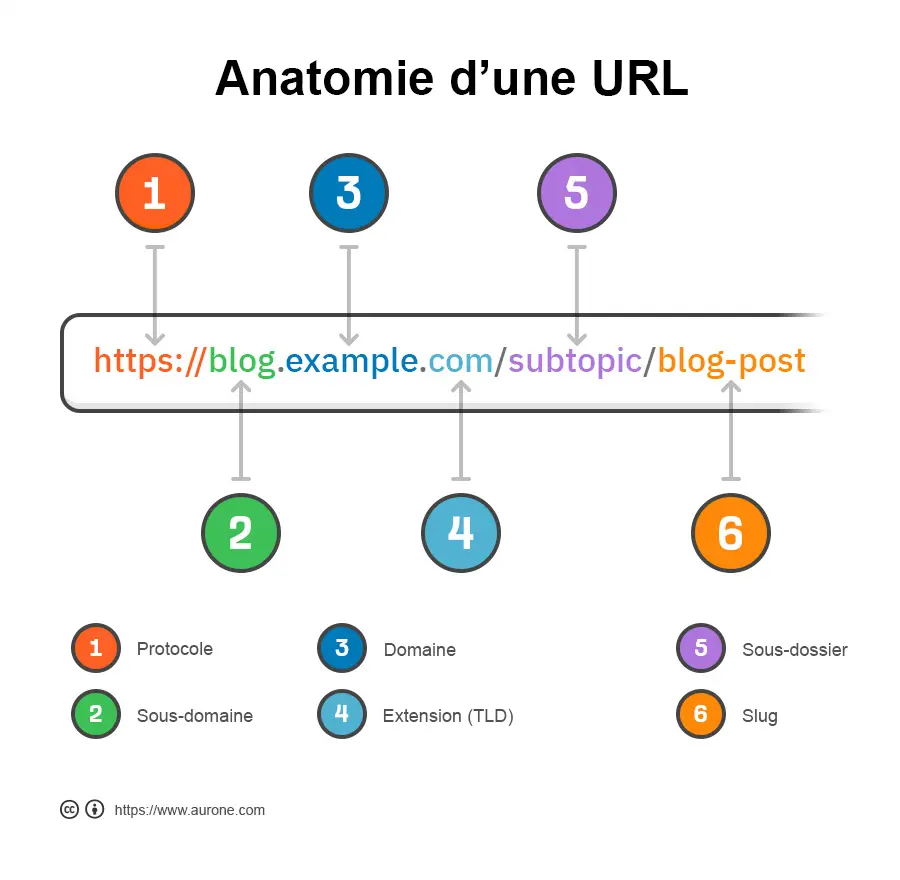

Avoir une bonne structuration d’URL

L’architecture des URL est une composante essentielle pour faciliter la compréhension de votre site par les moteurs de recherche. Voici mes recommandations pour garantir une structuration d’URL efficace.

- Ayez des URLs logiques : Communiquez clairement le contenu de la page à travers l’URL. Par exemple, optez pour une structure qui indique la hiérarchie, comme « votresite.com/page-categorie/nom-article ». Cette approche aide Google à comprendre le contexte du contenu.

- Utilisez les tirets : Pour séparer les mots dans les URL, utilisez des tirets (-). Les moteurs de recherche comprennent les tirets comme des espaces, améliorant ainsi la lisibilité. Par exemple, préférez « votre-site » à « votre_site » ou « votreSite ».

- Préférez les URLs courtes : Favorisez des URL courtes et pertinentes. Des adresses concises sont plus faciles à comprendre pour les moteurs de recherche et les utilisateurs. Limitez-vous à des termes clés pertinents pour la page.

- Évitez les caractères spéciaux : Limitez l’utilisation de caractères spéciaux dans les URL, car ils peuvent causer des problèmes d’encodage. Optez pour des URL proprement formatées, sans accents ou caractères spéciaux complexes.

- Utilisez des mots-clés pertinents : Intégrez des mots-clés pertinents dans vos URL. Ces mots-clés doivent refléter le contenu de la page et aider Google à comprendre le sujet. Évitez cependant le sur-optimisation.

- Limitez les niveaux de profondeur : Maintenez une structure d’URL plate en limitant le nombre de niveaux de profondeur. Des URL trop complexes peuvent rendre la navigation complexe pour les utilisateurs et les moteurs de recherche.

- Rendez vos URLs lisible : Assurez-vous que vos URL sont compréhensibles pour les utilisateurs. Si une personne peut déduire le contenu de la page à partir de l’URL, c’est un signe que vous avez une structuration efficace.

Comment vérifier l’indexation d’un site web ?

Lorsque vous aspirez à la domination en ligne, savoir si votre site est correctement indexé est essentiel. Voici quelques astuces qui vont vous permettre d’assurer que votre présence digitale est pleinement explorée par les moteurs de recherche :

Utilisez la recherche Google

Dirigez-vous vers le moteur de recherche Google et effectuez une recherche spécifique à votre site en utilisant la commande « site:votresite.com ». Cette requête fournira une liste complète des pages indexées par Google pour votre domaine. Examinez attentivement les résultats pour vous assurer que toutes les pages cruciales sont présentes et que le nombre correspond à vos attentes.

Utilisez la Google Search Console

Connectez-vous à la Google Search Console, votre tableau de bord privilégié pour surveiller l’indexation de votre site. Dans la section « Index », explorez les rapports disponibles. Vérifiez le nombre de pages indexées et examinez les éventuels avertissements ou erreurs signalés par Google. Cette étape vous donne une vision approfondie de la manière dont Google perçoit et indexe votre site.

Analysez votre fichier robots.txt

Accédez directement à votre fichier robots.txt en ajoutant « /robots.txt » à la fin de votre domaine (www.votresite.com/robots.txt). Cela vous permet de vérifier les directives que vous donnez aux robots d’exploration. Assurez-vous que les pages que vous souhaitez indexer ne sont pas bloquées et que votre fichier est correctement configuré pour une exploration optimale.

Scrutez votre fichier sitemap.xml

Accédez au fichier Sitemap.xml de votre site en ajoutant « /sitemap.xml » à la fin de votre domaine (www.votresite.com/sitemap.xml). Le Sitemap est une carte du trésor pour les moteurs de recherche. Assurez-vous qu’il est à jour, bien structuré, et qu’il liste toutes les pages importantes de votre site. Chaque URL doit être valide et représentative de votre contenu.

Utilisez des Outils

Utilisez des outils tels que SEMrush ou Ahrefs. Ces plates-formes offrent des analyses approfondies sur l’indexation, fournissant des métriques précises telles que le nombre de pages indexées, les liens entrants, et d’autres indicateurs clés de performance SEO. Utilisez ces données pour obtenir des perspectives externes et identifiez des domaines d’amélioration potentiels pour renforcer votre positionnement en ligne.

Lorsque mon site est indexé sur Google, est-il indexé sur les autres moteurs de recherche ?

L’indexation de votre site sur Google n’assure pas automatiquement une présence similaire sur les autres moteurs de recherche tels que Bing, Yahoo! ou d’autres. Chaque moteur de recherche opère indépendamment avec ses propres robots d’exploration, algorithmes, et critères d’indexation. Ainsi, bien que Google demeure prédominant, une visibilité équivalente sur d’autres plates-formes nécessite une optimisation spécifique

L’identité unique des robots de chaque moteur

Chaque moteur de recherche mobilise ses propres robots d’exploration. L’indexation sur Google ne garantit pas une parité d’exposition sur Bing ou Yahoo! ; chacun opère selon ses propres critères et préférences.

Les normes communes des moteurs de recherche

Bien que Google est le numéro 1, les autres moteurs de recherche suivent des normes d’indexation similaires. Des balises méta aux fichiers sitemap.xml, les bonnes pratiques SEO sont les mêmes pour maximiser votre présence en ligne, indépendamment du moteur.

L’Importance cruciale des sitemaps :

L’inclusion d’un sitemap.xml détaillé sur votre site offre une boussole précieuse aux bots de recherche. Cela facilite l’indexation, non seulement sur Google, mais également sur les autres moteurs de la recherche en ligne. Veillez à ce que votre sitemap soit bon et valide.

Qu’est-ce que l’index principal et l’index secondaire ?

il est essentiel de connaître les mécanismes d’indexation de Google. Les moteurs de recherche ne traitent pas tous les sites de la même manière. La pertinence et la qualité du contenu jouent un rôle crucial dans ce processus.

L’index principal de Google

Dans le monde du SEO, l’index principal de Google représente le cœur des résultats de recherche. Ce sont les pages que Google considère comme les plus pertinentes et de haute qualité. Elles sont donc privilégiées dans les premières pages de résultats.

Pour qu’un site web figure dans cet index, il est crucial de se concentrer sur la pertinence, la qualité du contenu et l’optimisation SEO. Des pratiques telles que l’utilisation de mots-clés pertinents, la création de contenu original et utile, et une bonne expérience utilisateur sont essentielles.

L’index secondaire de Google

L’index secondaire, en revanche, contient des pages jugées moins pertinentes ou de qualité inférieure. Ces pages sont moins susceptibles d’apparaître en haut des résultats de recherche, impactant négativement la visibilité du site.

Plusieurs facteurs peuvent reléguer une page à l’index secondaire, comme un contenu dupliqué, un faible nombre de mots, ou un manque d’optimisation SEO. Comprendre ces facteurs est crucial pour éviter que le site ne soit pénalisé.

Exemple d’index principal

Imaginons un article de blog bien rédigé sur « Les meilleures pratiques SEO en 2024 ». Ce contenu, riche en informations utiles, optimisé pour les mots-clés pertinents, et offrant une bonne expérience utilisateur, a toutes les chances de se classer dans l’index principal.

Exemple d’index secondaire

Considérons maintenant une page contenant une brève description de produit, avec peu de texte et aucune optimisation SEO. Cette page risque d’être classée dans l’index secondaire, car elle offre une valeur limitée aux utilisateurs et aux critères de Google.

Comment ne pas indexer son site sur Google ?

Dans certains cas, vous pourriez vouloir éviter l’indexation de votre site par Google. Cela peut être pertinent pour des sites en développement, des plateformes internes, ou pour protéger des contenus sensibles. Voici des méthodes efficaces pour empêcher l’indexation d’un site sur Google :

- Utilisation du fichiers robots.txt :

Pour empêcher l’indexation, ajoutez des règles spécifiques dans ce fichier. Par exemple, « User-agent: * Disallow: / » bloque l’accès à tout le site. - Utilisation de la balise meta robots :

Pour bloquer l’indexation, insérez « <meta name=’robots’ content=’noindex, nofollow’> » dans l’en-tête HTML de chaque page. - Configuration du serveur :

Utilisez le fichier .htaccess pour définir des règles qui bloquent les adresses IP des robots de Google.

Empêcher l’indexation de votre site sur Google nécessite une stratégie réfléchie. Que ce soit par le fichier robots.txt, la balise meta robot ou la configuration du serveur. Choisissez la plus adaptée à vos besoins pour une gestion efficace de la visibilité de votre site.

Pourquoi votre site n’est pas indexé ?

Comprendre pourquoi un site n’est pas indexé par Google est crucial pour tout propriétaire de site web. Plusieurs raisons peuvent expliquer cette absence d’indexation, et les identifier est la première étape vers une visibilité accrue :

- Problèmes de crawling et d’indexation :

Un site récemment lancé peut ne pas être immédiatement indexé. Google prend du temps pour découvrir et crawler de nouveaux sites. De plus, vous avez certainement des erreurs d’indexation. Les erreurs dans le fichier robots.txt ou les balises meta robots peuvent empêcher Google de crawler ou indexer votre site. - Problèmes techniques du site :

Un temps de chargement lent peut dissuader les robots de Google de parcourir efficacement votre site. Les erreurs 5xx peuvent aussi interrompre le processus de crawling. - Contenu et SEO on-page :

Un contenu pauvre, dupliqué ou mince peut rendre votre site moins attractif pour l’indexation. De plus, une mauvaise structuration de site peut nuire au crawling et à l’indexation - Pénalités de Google :

L’utilisation de techniques de SEO « Black Hat » peuvent entraîner des pénalités et bloquer l’indexation.

Les articles qui peuvent vous intéresser :

Tombé dans le SEO depuis deux ans et avec une expérience dans le domaine, Souleymane optimise la visibilité en ligne des entreprises et des entrepreneurs. Doté d’une compréhension des algorithmes de recherche, il apporte une approche stratégique et personnalisée à chaque projet. Souleymane partage ses connaissances à travers diverses articles.