Guide complet sur le cloaking User-Agent

Dans l’écosystème complexe du référencement en ligne, le cloaking user agent demeure une pratique intrigante. Cette stratégie, utilisée pour présenter différents contenus aux utilisateurs et aux moteurs de recherche, suscite à la fois intérêt et controverses dans le domaine du SEO.

Note importante : Je ne vous conseille pas de tester cette technique si vous avez peu de connaissance technique dans le web !!

Définition : Qu’est-ce que le cloaking-user agent ?

Le cloaking user agent est une technique avancée de référencement web utilisée pour présenter différents contenus aux utilisateurs et aux moteurs de recherche. Cette stratégie vise à afficher du contenu optimisé pour le référencement (SEO) lorsque les moteurs de recherche visitent une page, tout en montrant un contenu différent aux internautes.

Comment marche le cloaking user-agent ?

Le fonctionnement du cloaking user-agent repose sur la détection de l’en-tête user-agent des requêtes HTTP. Chaque fois qu’un utilisateur visite une page web, son navigateur envoie une requête au serveur web contenant des informations sur le navigateur et le système d’exploitation utilisés. Cette information est encapsulée dans l’en-tête user-agent.

Lorsque le serveur reçoit une requête, il vérifie l’en-tête user-agent pour déterminer s’il s’agit d’un bot de moteur de recherche ou d’un internaute. Si la requête provient d’un bot de moteur de recherche, le serveur renvoie une version de la page spécialement optimisée pour le référencement. Cette version peut contenir un contenu riche en mots-clés, des suites de liens internes, etc…

En revanche, si la requête provient d’un internaute, le serveur renvoie une version différente de la page, conçue pour une expérience utilisateur optimale. Cette version peut inclure des éléments interactifs, des images de haute qualité, des animations, etc.

Cela permet aussi de ne pas perdre du budget crawl et de ne pas donner des informations qui peuvent être inconnue pour les bots ! Il y a quelques instants je vous parlais d’animations. Si vos animations sont faîtes avec du JavaScript, cela va alourdir votre site et le Googlebot (le robot de Google) n’arrivera pas analyser ce type de langage c’est donc super intéressant.

Le cloaking user-agent peut être mis en œuvre de différentes manières, notamment par le biais de scripts côté serveur ou de règles de redirection conditionnelles basées sur l’en-tête user-agent. On est sur le web ! Il y a de multiples façons de faire du cloaking (c’est important pour la suite car je vais sûrement prendre une manière de faire.)

Qu’est-ce que l’en-tête user-agent ?

L’en-tête user-agent est une chaîne de caractères envoyée par le navigateur web d’un utilisateur à un serveur web lorsqu’il accède à une page. Cette chaîne identifie le navigateur utilisé, la version du navigateur, le système d’exploitation et d’autres informations pertinentes.

Dans la stratégie de cloaking user-agent, l’en-tête user-agent est utilisé pour distinguer les requêtes des moteurs de recherche de celles des internautes traditionnelles comme vous et moi. Cette distinction permet au serveur web de fournir du contenu différent en fonction de l’entité qui accède à la page.

Exemple d’en-tête user agent internaute

Par exemple, supposons qu’un utilisateur visite une page web à l’aide du navigateur Google Chrome sur un ordinateur Windows. L’en-tête user-agent envoyé à partir de ce navigateur pourrait ressembler à ceci :

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36

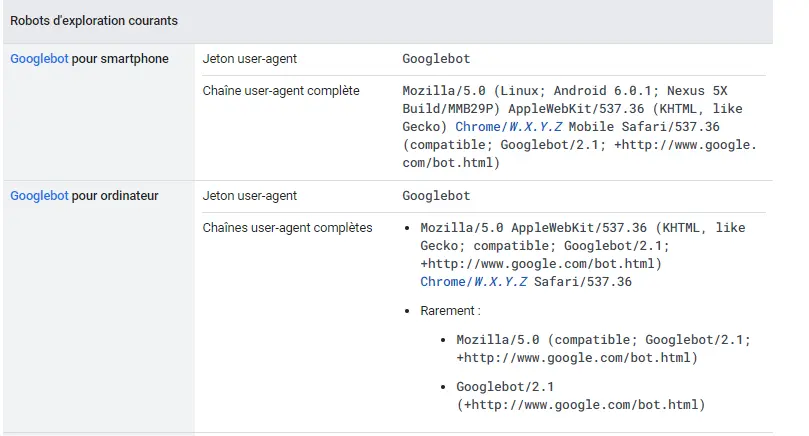

Exemple d’en-tête user agent pour les bots

Voici un exemple d’en-tête user-agent pour le Googlebot (le bot d’indexation de Google) :

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Les exemples c’est sympa mais voici les officiels en-tête user-agent des googlebots sur smartphone et mobile : (ne me remerciez pas)

Pourquoi utiliser le cloaking user-agent ?

Lorsqu’il s’agit d’optimiser le référencement (SEO) d’un site web, des défis surgissent souvent, notamment en ce qui concerne la gestion de contenus tels que des vidéos, des fichiers audio. Ces éléments peuvent poser problème lors de l’indexation par les Googlebots, entravant ainsi la visibilité et le classement dans les résultats de recherche. C’est là que le cloaking user-agent entre en jeu, offrant une solution astucieuse pour maximiser le SEO malgré ces obstacles.

Imaginons une situation où nous cherchons à pousser au maximum l’optimisation SEO de notre site, mais nous sommes confrontés à ces contenus difficiles à analyser pour les Googlebots. Ces derniers peuvent rencontrer des difficultés avec des éléments tels que les vidéos, les fichiers audio et les images sans balises alt, tout comme avec l’exemple du javascript, comme évoqué précédemment.

Dans ce contexte, le cloaking user-agent devient une stratégie pertinente. Il permet de créer deux versions distinctes du site : une pour les bots de Google et une pour les utilisateurs humains :

- Site pour les bots :

Dans la version destinée aux bots, on s’assure de ne placer aucun contenu complexe à analyser, tel que les vidéos et les fichiers audio. Au lieu de cela, l’accent est mis sur du texte optimisé, du maillage interne, une structuration appropriée avec l’utilisation de balises HTML comme les Hn, et une optimisation du maillage interne. Cette version du site est conçue spécifiquement pour maximiser le référencement, offrant aux moteurs de recherche un contenu facilement compréhensible et indexable.

D’ailleurs, c’est sur cette version du site que le SEO est le plus optimisé, car nous savons que les bots des moteurs de recherche - Site pour les internautes :

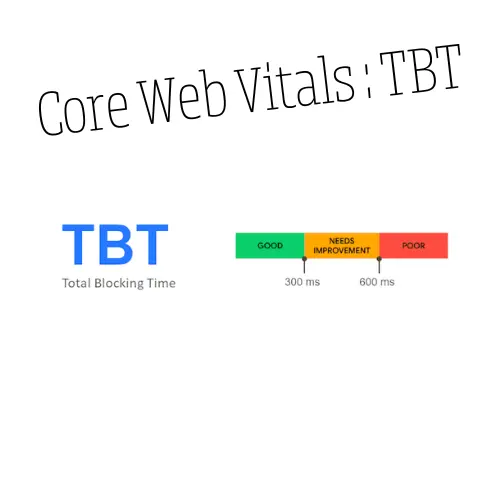

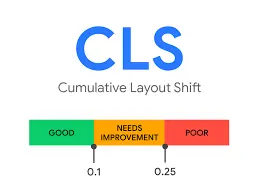

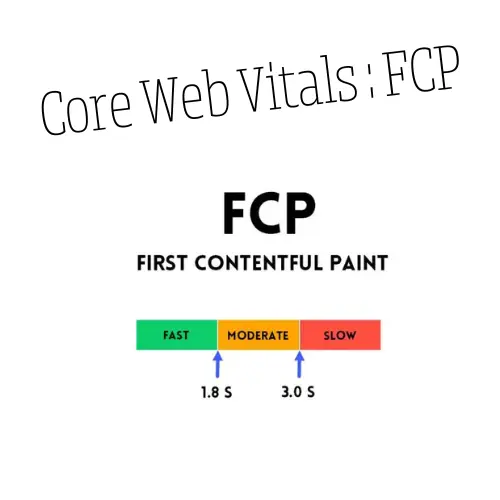

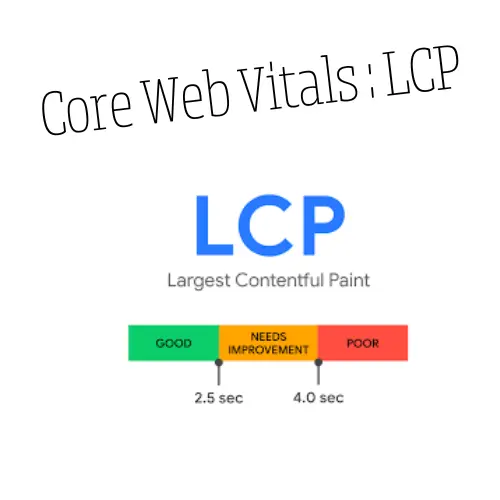

En revanche, la version destinée aux utilisateurs humains est axée sur l’expérience utilisateur. On maintient un aspect visuel attrayant et une convivialité maximale, même si cela signifie inclure des éléments tels que des vidéos et des fichiers audio que les bots ont du mal à analyser. Cependant, cela se fait en respectant les Core Web Vitals pour garantir une expérience utilisateur fluide et satisfaisante.

De plus, on peut réintégrer le contenu complexe que les bots ont du mal à analyser dans cette version du site, offrant ainsi aux utilisateurs une expérience complète et engageante.

En utilisant le cloaking user-agent de manière stratégique, il est possible de concilier les exigences des moteurs de recherche avec les impératifs de l’expérience utilisateur, offrant ainsi un compromis optimal pour maximiser le référencement tout en garantissant une expérience de navigation de qualité.

Comment vérifier si le cloaking a bien marché ?

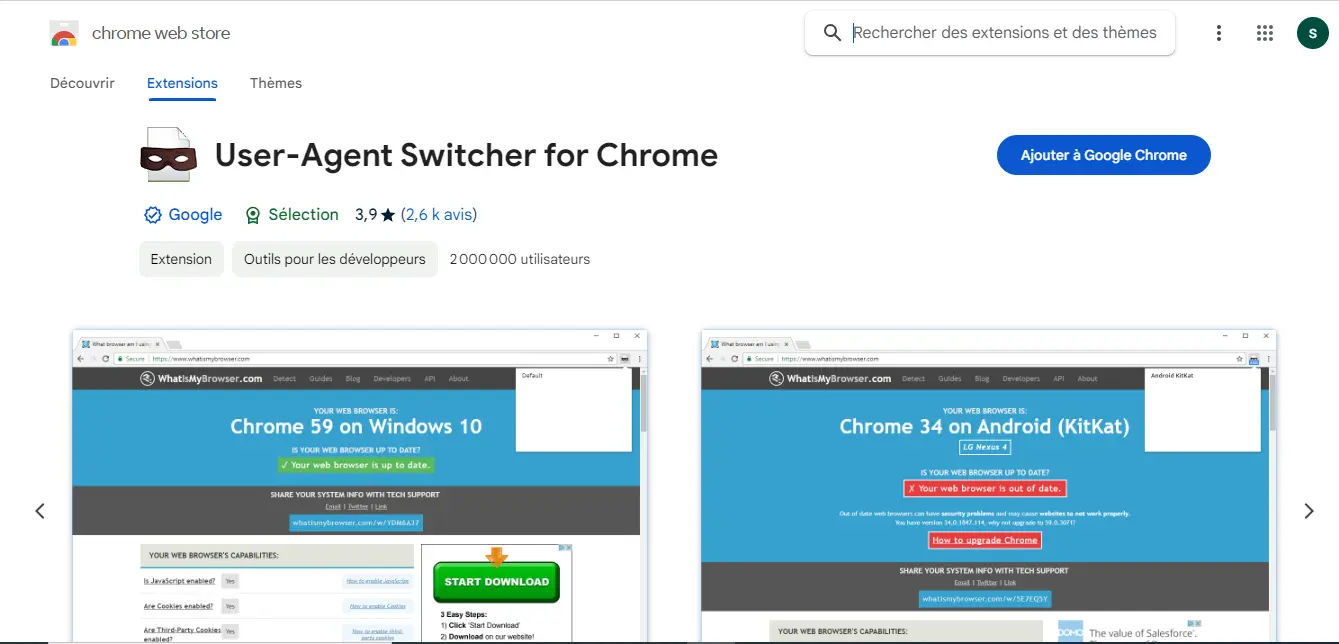

Lorsqu’il s’agit de vérifier l’efficacité du cloaking sur un site web, plusieurs méthodes peuvent être utilisées pour s’assurer que le contenu présenté aux utilisateurs et aux moteurs de recherche est conforme aux attentes. Dans notre cas je vais en parler d’un seul c’est celui avec l’extension User-Agent switcher.

Utilisation de l’extension Chrome User-Agent Switcher :

L’extension Chrome User-Agent Switcher permet de naviguer sur un site web en utilisant l’user-agent du Googlebot, ce qui permet de vérifier si le cloaking a été correctement implémenté. Voici comment procéder :

- Installer l’extension : Ouvrez le Chrome Web Store et recherchez « User Agent Switcher ». Installez l’extension dans votre navigateur Chrome.

- Configurer l’user-agent : Une fois l’extension installée, cliquez sur son icône dans la barre d’outils de Chrome. Sélectionnez « Options » ou « Paramètres » pour accéder à la configuration de l’extension.

- Ajouter l’user-agent du Googlebot : Copiez et collez l’user-agent suivant dans le champ approprié de l’extension :

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) ou le lien suivant : https://t.co/Om6gEi0c7N - Naviguer sur le site : Après avoir configuré l’user-agent, accédez au site que vous souhaitez vérifier. Parcourez les différentes pages pour voir le contenu tel que le Googlebot le verrait.

Quels sont les risques du cloaking User-Agent ?

L’utilisation du cloaking User-Agent, bien que pouvant sembler attrayante pour optimiser le référencement, comporte des risques significatifs. Ces risques peuvent avoir des implications néfastes sur la visibilité et la réputation de votre site web.

Impact sur le classement

Le cloaking peut entraîner des pénalités de la part des moteurs de recherche, y compris une baisse de classement voire une exclusion complète de l’index.

Violations des directives des moteurs de recherche :

Le cloaking est souvent en contradiction avec les directives des moteurs de recherche, notamment celles de Google. Cela peut entraîner des actions manuelles de la part de Google, telles que des pénalités algorithmiques ou manuelles. D’ailleurs, les pénalités manuelles sont rares de nos jours mais on est à l’abris de rien !

Comment faire un cloaking user-agent ?

Voici ce que vous devez savoir pour le mettre en place, je vais passer en revue ce que j’ai dis tout au long de l’article avec certains points que je n’ai pas forcément abordés :

- Comprendre le fonctionnement du cloaking user-agent :

Le cloaking user-agent implique de présenter différents contenus aux moteurs de recherche et aux utilisateurs. Cette stratégie vise à optimiser le référencement tout en offrant une expérience utilisateur de qualité. - Identifier les contenus à cloaker :

Identifiez les types de contenus difficiles à analyser pour les moteurs de recherche, tels que les vidéos, les fichiers audio et les images sans balises alt. Ces éléments peuvent bénéficier du cloaking pour améliorer leur indexation. - Configurer le cloaking sur le serveur :

Mettez en place des règles de redirection sur le serveur pour détecter l’en-tête user-agent des requêtes entrantes. En fonction de cet en-tête, servez le contenu approprié aux moteurs de recherche ou aux utilisateurs. - Créer deux versions du site :

Développez deux versions distinctes du site : une pour les moteurs de recherche et une pour les utilisateurs. Assurez-vous que la version destinée aux moteurs de recherche est optimisée pour le référencement, tandis que celle destinée aux utilisateurs offre une expérience utilisateur optimale. - Tester et ajuster :

Effectuez des tests réguliers pour vous assurer que le cloaking fonctionne correctement. Vérifiez que les moteurs de recherche voient le contenu optimisé pour le référencement et que les utilisateurs voient une version conviviale du site. Utilisez l’outil User-Agent Switcher pour simuler la vision du Googlebot. Ce type d’outil est précieux pour vérifier l’efficacité de votre cloaking. - Surveiller les performances :

Surveillez les performances de votre site après avoir mis en œuvre le cloaking. Analysez les données de référencement, telles que le classement dans les résultats de recherche et le trafic organique, pour évaluer l’impact de cette stratégie.

Conclusion

Pour conclure, bien que le cloaking User-Agent est une stratégie SEO qui semble offrir des avantages en termes d’optimisation du référencement, il est crucial de considérer attentivement les risques associés. Bien-sûr, je vous recommande de suivre les meilleures pratiques recommandées par les moteurs de recherche pour éviter les conséquences néfastes sur la visibilité et la réputation de votre site.

Les articles qui peuvent vous intéresser :

Tombé dans le SEO depuis deux ans et avec une expérience dans le domaine, Souleymane optimise la visibilité en ligne des entreprises et des entrepreneurs. Doté d’une compréhension des algorithmes de recherche, il apporte une approche stratégique et personnalisée à chaque projet. Souleymane partage ses connaissances à travers diverses articles.